【18日目】Self-Supervised Graph Transformer on Large-ScaleMolecular Data

この記事はNLP/CV論文紹介 Advent Calendar 2020の18日目の記事です。

今日は分子のデータに対して適用するための、GNNとTransformerを組み合わせたGROVERというモデルです。

0. 論文

[2007.02835] Self-Supervised Graph Transformer on Large-Scale Molecular Data

Yu Rong, Yatao Bian, Tingyang Xu, Weiyang Xie, Ying Wei, Wenbing Huang, Junzhou Huang

1. どんなもの?

分子データに適用するために、GNNとTransformerを組み合わせたGROVERの提案

2. 先行研究と比べてどこがすごい?

単純にGNNとTransformerを組み合わせるのではなく、グラフの局所構造を抽出するDyMPNとそれにMulti-Head Attentionをモデルに組み込んで性能を向上させているところ

3. 技術や手法のキモはどこ?

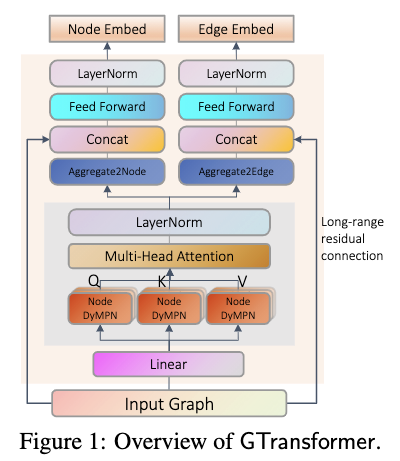

グラフの局所構造を抽出してくるためにランダム性を持たせつつMessage Passingで局所構造を捉えるGNNのDyMPN(Dynamic Message Passing Network)と、捉えた局所構造達に対してMulti-Head Attentionを行うTransformerを組み合わせたGTransformer(GNN Transformer)、そしてこれを使ってグラフから特徴抽出を行い予測を行うGROVERを提案。

これに、「nodeに対応するGtransformerの出力からそのnodeの周辺の原子と結合を予測するタスク」と「グラフの局所構造を予測するタスク」の2つの事前学習を行なって学習を行う。

事前学習には11Mのラベルなし分子データを用いた。

4. どうやって有効だと検証した?

11種類のデータセットでMoluculeNetなどの既存手法と比較。GLOVER-largeモデルでは全てのデータセットと既存手法を圧倒。

5. 議論はある?

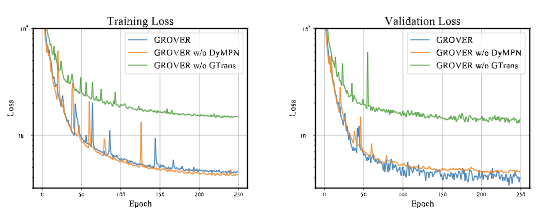

DyMPNとTransformerを組み合わせたGTransformerの構造が性能に大きく寄与していそう