【19日目】Distribution-Balanced Loss for Multi-Label Classification in Long-Tailed Datasets

この記事はNLP/CV論文紹介 Advent Calendar 2020の19日目の記事です。

今日はマルチクラス分類で、ラベルの不均衡さを克服するためにラベルの共起などを用いたLossを提案する論文です。

0. 論文

Distribution-Balanced Loss for Multi-Label Classification in Long-Tailed Datasets

Tong Wu, Qingqiu Huang, Ziwei Liu, Yu Wang, Dahua Lin

1. どんなもの?

マルチクラス分類で、クラスの共起やnegative-logitsに補正を加えたLoss「Distribution-Balanced Loss」による学習を提案

2. 先行研究と比べてどこがすごい?

学習バッチを作る際、単純なクラスの割合によるサンプリングではなく、クラスの共起も考慮したサンプリングを行う。またマルチクラス分類でよく用いられるBCEに対して補正を加えた。

3. 技術や手法のキモはどこ?

マルチクラス分類では、学習バッチ作成の際のサンプリングでラベル間の共起を考慮できていない問題や、BCE Lossがクラスごとにsigmoidを計算するためクラスごとのlogit計算が独立しておりサンプル数が少ないクラスだと負例として扱われることが多くその場合logitが低く抑えられがちという問題がある。

こういった問題を解決するために、前者にはサンプリングしたあとにラベル間共起を考慮してLossを調節するR-BCE、後者にはlogitの小さな変化に反応できその反応度合いをパラメータで制御できるNT-BCE、そしてこれらをmixしたDistribution-Balanced Lossを提案した。

4. どうやって有効だと検証した?

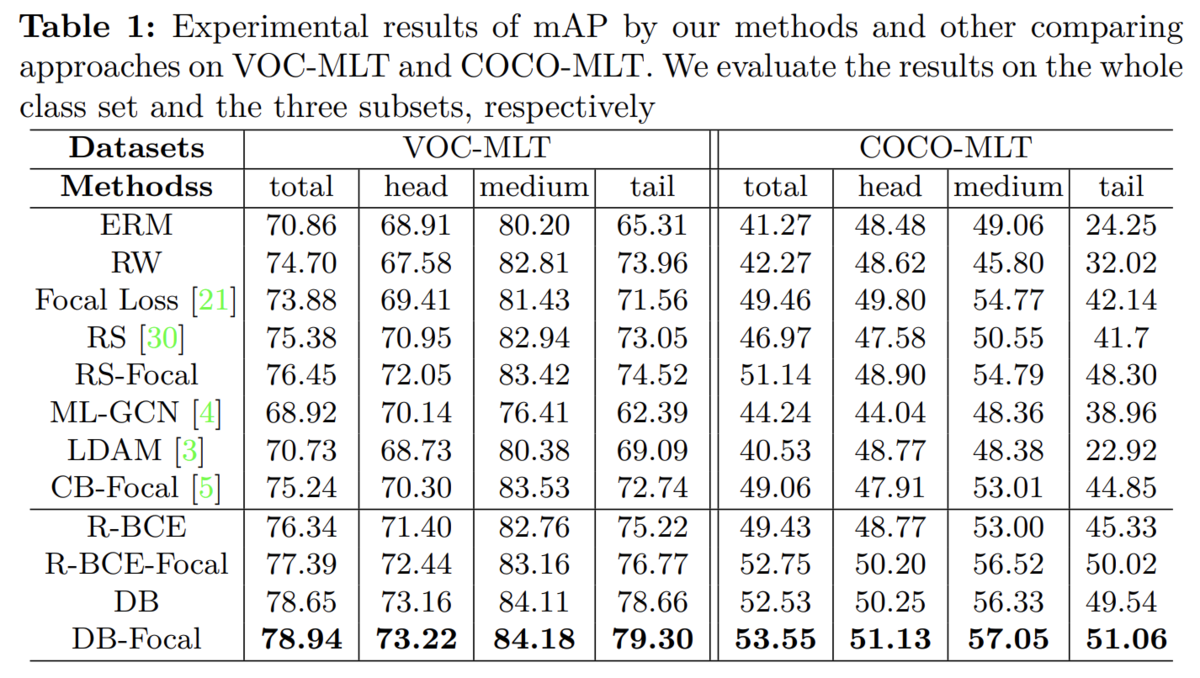

クラスをlong tailな分布にしたCOCO-MLTとVOC-MLTで実験。クラスサンプルに偏りがあるような状況での実験を行なった。 実験の結果、特にサンプル数が少ないtailなクラスで大幅な改善が見られた